- Was genau ist ChatGPT?

- Aber wie macht es das alles? Arman, wie funktioniert ChatGPT?

- Moment mal, LLMs, generative KI, Parameter, was ist das eigentlich?

- Gut, es handelt sich also um einen Chatbot, der Nuancen versteht und seine eigenen Antworten generieren kann. Was sind Ihrer Meinung nach die größten Vor- und Nachteile dieser Entwicklung?

- ChatGPT vs. konversationelle KI

- Was ist der Unterschied zwischen ChatGPT und Conversational AI Cloud?

- OK, das Publikum und die Anwendungsfälle sind also sehr unterschiedlich?

- CM.com & ChatGPT

- Welche Rolle kann ChatGPT in unseren Produkten spielen?

- Sagen Sie uns, was bauen wir gerade, und was können wir in Zukunft erwarten?

- Die Zukunft beginnt heute

- Was bedeutet ChatGPT für Unternehmen heute und in Zukunft?

Was genau ist ChatGPT?

ChatGPT ist eine Chat-Schnittstelle, die auf den Large Language Models (LLMs) der GPT-Reihe von OpenAI basiert. Sie können es fragen, was immer Sie wollen, und ihm Befehle geben, um strukturierte Informationen zu generieren. Denken Sie an Anwendungsfälle wie das Stellen einer Frage, die Übersetzung eines Textes, die Durchführung von Berechnungen auf der Grundlage einer Problembeschreibung, die Generierung von Code für eine Funktion, an die Sie denken, und die Liste geht weiter...

Aber wie macht es das alles? Arman, wie funktioniert ChatGPT?

Also, ChatGPT ist ein Produkt von OpenAI, das auf der GPT3.5-Serie basiert. Es ist ein Large Language Model (LLM) mit 20 Milliarden Parametern, das speziell für die Modellierung von Gesprächen trainiert wurde (sprich: von Hand). Das Modell besteht aus Natural Language Understanding (NLU), um Eingaben zu verstehen, und Natural Language Generation (NLG), um eine Antwort zu formulieren. Vor allem der letzte Teil, NLG, hat mit der Einführung von ChatGPT erhebliche Fortschritte gemacht und ermöglicht nun bessere "generative" KI-Anwendungsfälle.

Moment mal, LLMs, generative KI, Parameter, was ist das eigentlich?

Einfach ausgedrückt, handelt es sich um einen Algorithmus, der Text erkennt, zusammenfasst, übersetzt, vorhersagt und generiert. Möglich wird dies durch die riesigen Datensätze, die zum Trainieren des Modells verwendet werden. Eine Möglichkeit, seine Lernfähigkeit auszudrücken, ist die Quantifizierung der Anzahl der Parameter. Ein Parameter ist eine Variable, die den Teil des Modells ausmacht, der aus den historischen Daten des zugrunde liegenden Datensatzes lernen konnte. Die Anzahl der Parameter sagt also etwas darüber aus, wie viele Nuancen ein Modell aufnehmen kann. Bisher haben wir eine starke Korrelation zwischen der Anzahl der Parameter eines Modells und seiner Fähigkeit, menschenähnliche Reaktionen und Verhaltensweisen zu erzeugen, festgestellt

Gut, es handelt sich also um einen Chatbot, der Nuancen versteht und seine eigenen Antworten generieren kann. Was sind Ihrer Meinung nach die größten Vor- und Nachteile dieser Entwicklung?

Abgesehen von den Möglichkeiten und leistungsstarken neuen Anwendungsfällen, die diese Technologie mit sich bringt, sehe ich den Hype, der sie umgibt, als den größten Vorteil. Der außerordentliche Enthusiasmus führt zu einem Anstieg der Neugier und der Nachfrage nach Technologien der generativen KI. Dadurch wird die Leistungsfähigkeit der konversationellen KI öffentlich zur Schau gestellt, und die Menschen lieben es. Letztendlich wird dies die Innovation weiter vorantreiben, da sich mehr Menschen und Unternehmen daran beteiligen.

Es gibt auch einige anfängliche Schattenseiten. Wir haben festgestellt, dass es in der Anfangsphase dieser Art von Entwicklungen vielen Menschen schwer fällt, durch das Rauschen hindurchzusehen und den tatsächlichen Geschäftswert zu erkennen. ChatGPT wird als eine allwissende und allmächtige Technologie wahrgenommen, was nicht ganz richtig ist. Es handelt sich um ein KI-Modell für Unterhaltungen, das bei der Generierung natürlicher Sprache großartig ist, aber es ist nicht perfekt. Sie macht Fehler. Es ist in Ordnung, wenn seine Nutzer verstehen, dass es gelegentlich Dinge falsch macht und kein Allheilmittel ist. Diese Phase wird vorübergehen, und was dann übrig bleibt, wird äußerst beeindruckend sein.

ChatGPT vs. konversationelle KI

Menschenähnliche Unterhaltungen klingen wie etwas, das man auch mit Conversational AI Cloud erreichen will.

Was ist der Unterschied zwischen ChatGPT und Conversational AI Cloud?

Gute Frage. Die GPT-Serie von OpenAI ist eine großartige Anwendung der "neuen" Transformer-Architektur, die Google 2017 der Welt vorgestellt hat. Unsere Conversational AI Cloud verwendet schon seit Jahren Transformer-Modelle. Der große Unterschied besteht darin, was eine Conversational AI Platform um diese Modelle herum aufgebaut hat, um einen echten Geschäftswert für ein Unternehmen zu liefern.

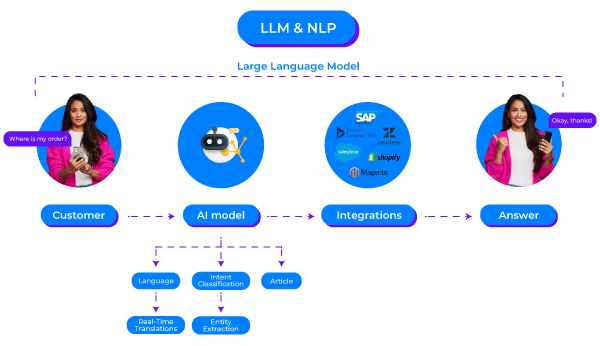

Conversational AI Cloud hilft Unternehmen bei der Lösung spezifischer Geschäftsprobleme durch die Automatisierung von Konversationen. Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) steht dabei im Mittelpunkt. Wenn Sie viele und/oder komplexe Fragen automatisieren müssen, stoßen Sie mit regelbasierten Modellen an Grenzen, sodass der Einsatz von KI-Modellen nur sinnvoll ist.

Für sich allein genommen bringen diese Modelle nicht viel. Unternehmen wollen KI in Webchat, WhatsApp und anderen Kanälen einsetzen. Sie wollen ihre Modelle testen, bevor sie neue Versionen bereitstellen. Und sie wollen Inhalte einfach hinzufügen oder aktualisieren, wenn sie beispielsweise ihre Preise aktualisieren oder einen neuen Gesprächsverlauf hinzufügen müssen. Sie möchten Einblicke in ihre KPIs wie Modellleistung oder Ablenkungsrate erhalten. Und wie sieht es mit Integrationen in bestehende Systeme wie OMS, CDP, CRM oder ERP aus? Wenn Sie mit Ihrer Conversational AI keine echten Aktionen ausführen können, wie z. B. das Abrufen oder Aktualisieren von Datensätzen, um Kunden Status-Updates zu geben oder ihre Informationen zu ändern, dann können Sie nicht viel tun. ChatGPT kann nichts von alledem tun. Aber mit Conversational AI Cloud können Sie das. Die Modelle, die wir "unter der Haube" verwenden, ergänzen also eine breite Palette von Fähigkeiten, die unsere Gesamtlösung ausmachen.

Die von der Conversational AI Cloud gegebenen Antworten können sich an den Kontext anpassen, werden aber von den Textern in Ihrem Unternehmen überprüft, um sicherzustellen, dass die Antworten immer sachlich korrekt sind, der Marke entsprechen und den richtigen Tonfall haben. Je nachdem, wie gut Ihre Umgebung eingerichtet ist, kann das Schlimmste, was passieren kann, sein, dass Ihre KI in einem geringen Prozentsatz der Fälle mit "Ich weiß die Antwort auf diese Frage nicht" antwortet. Doch selbst dieser Satz wird genau so formuliert, wie Sie es wünschen, und dieser Fluss wird vollständig kontrolliert. All diese Grundsätze führen zu einem risikoarmen Profil für die Nutzung der Conversational AI Cloud zur Interaktion mit Ihren Kunden.

Und hier liegt auch gleich der große Unterschied zwischen ChatGPT und Conversational AI Cloud. Das Verhalten von ChatGPT ist das, was man eine Blackbox nennen würde. Stellen Sie dieselbe Frage fünf Mal und Sie werden fünf verschiedene Antworten erhalten (oder auch nicht, Sie werden nie sicher sein). Manchmal hört sich eine dieser Antworten zwar gut an, ist aber auch sachlich falsch. Ihre KI, die sich die Antworten auf der Stelle ausdenkt, spart Ihnen ein, vielleicht zwei Vollzeitäquivalente an Verwaltungsarbeit. Aber gleichzeitig verringert sich Ihre Fähigkeit, Kontrolle auszuüben, transparent zu sein und die Qualität aufrechtzuerhalten. Das Risikoprofil einer generativen KI, die direkt an Ihre Kunden weitergegeben wird, ist also deutlich höher (zumindest jetzt, wo wir noch in den Anfängen dieser Technologie stehen). Irgendwann werden wir diesen Punkt überwinden, aber nicht heute.

OK, das Publikum und die Anwendungsfälle sind also sehr unterschiedlich?

So kann man es gut zusammenfassen. Unsere Modelle werden sich weiter entwickeln, wie sie es in der Vergangenheit getan haben. Und ich bin sicher, dass die LLMs, die derzeit entwickelt und veröffentlicht werden, die Möglichkeiten unserer Produkte erheblich erweitern werden. Sie werden sie nicht kannibalisieren; dies sind zwei verschiedene, sich ergänzende Dinge.

CM.com & ChatGPT

Also, Arman, wenn Sie sagen, dass diese Modelle unsere Produkte verbessern werden, was bedeutet das? Und hat CM.com irgendwelche Pläne für die Einführung dieser neuen Modelle?

Welche Rolle kann ChatGPT in unseren Produkten spielen?

Wir sehen viele Möglichkeiten, unsere Produkte zu verbessern und die Nutzer unserer Produkte und die Arbeit, die sie in den letzten Jahren geleistet haben, weiter zu unterstützen. Egal, ob es sich um einen Konversationsdesigner in der Conversational AI Cloud, einen Agenten in der Mobile Service Cloud oder einen Marketeer in unserer Mobile Marketing Cloud handelt. Sie alle generieren Inhalte. Der Einsatz von generativer KI zur Erstellung von Inhaltsvorschlägen und die abschließende Prüfung durch unsere Kunden nimmt ihnen eine Menge Arbeit ab.

Wichtig ist für uns, dass wir uns nicht von dem Hype mitreißen lassen und diese Technologien nur um ihrer selbst willen integrieren. Wir wollen nur Funktionen implementieren, die für unsere Produkte und Kunden einen erheblichen Mehrwert darstellen. Es geht uns nicht darum, unsere Fähigkeiten marketinggesteuert mit "KI-gestützt dies, KI-gestützt das" zu etikettieren. Generative KI und LLMs sind mächtig und machen an vielen Stellen Sinn, aber wir sind uns der Nachteile bewusst und stellen sicher, dass alle neuen Funktionen, die wir anbieten, Qualität und Wert liefern.

Sagen Sie uns, was bauen wir gerade, und was können wir in Zukunft erwarten?

Ich bin froh, dass Sie fragen. Wir haben einiges in der Pipeline, das unsere Herzen höher schlagen lässt. Werfen wir einen Blick auf einige von ihnen.

Generierung von konversationellen Inhalten

Unser Ziel ist eine schnellere Inbetriebnahme für unsere Conversational AI-Kunden, ganz gleich, ob es sich um einen neuen Kunden handelt, der gerade erst anfängt, oder um einen bestehenden Kunden, der einen neuen Conversational Flow hinzufügen möchte. Wir sind zwar stolz auf unsere Benutzerfreundlichkeit, aber das Einrichten von Intent-Modellen und Artikelstrukturen kostet Zeit. Diese Zeit kann erheblich verkürzt werden, wenn Sie als Konversationsdesigner sozusagen einen Ghostwriter haben, der die schwere Arbeit für Sie erledigt. Kurzfristig bedeutet das, dass Sie Conversational AI Cloud mit Informationen über Ihr Unternehmen versorgen. Nehmen wir an, Sie sind ein Versorgungsunternehmen. Sie können diese Tatsache mitteilen und einige geringfügige Details über Ihre Produkte und Dienstleistungen angeben - woraufhin das LLM automatisch Fragen und Anerkennungspunkte generiert, die Sie sehr wohl von Ihren Kunden erwarten können. Sie können Ihren Output nach der Aufforderung als Entwurf betrachten, ihn überprüfen, testen und veröffentlichen. Sich selbst Gedanken über den Inhalt zu machen, nimmt eine Menge Zeit in Anspruch, die Sie anderweitig hätten nutzen können.

Wir beginnen mit Intents und haben bereits mehrere andere Bereiche identifiziert, die von dieser Art von Lösung profitieren werden. Im Laufe der Zeit werden wir das CM.com-Portfolio um immer mehr dieser Funktionen erweitern.

LLMs für natürliche Sprachverarbeitung in Echtzeit

Eine Sache, an der wir ständig arbeiten, sind unsere NLP-Modelle in unserer Conversational AI Cloud und die Erleichterung des Lebens von Agenten in unserer Mobile Service Cloud. Das Ziel ist es, unsere bestehende NLP-Infrastruktur mit der Leistung von LLMs zu verbessern, indem wir Themen wie Zero- und Little-Shot-Erkennung untersuchen. Und auch hier konzentrieren wir uns auf den Wert, den dies für unsere Produkte haben wird. Stärkere Erkennungsmodelle bedeuten weniger Eskalationen zu Live-Agenten, und ein feinkörnigeres Routing bei Eskalationen führt zu einer geringeren durchschnittlichen Bearbeitungszeit pro Gespräch. All dies wird der gesamten CM.com-Plattform einen erheblichen Mehrwert verleihen. Darüber hinaus befassen wir uns auch mit Themen wie Rechtschreib- und Grammatikkorrekturen, um Gesprächsdesignern, Contact Center-Agenten und Marketingexperten zu helfen.

Personalisierung durch Gefühle

ChatGPT ist ein gutes Beispiel dafür, wie sentimentaler Kontext Antworten verbessern kann. Wenn eine negative Stimmung festgestellt wird, können wir diese ausgleichen, indem wir statische Antworten so umformulieren, dass sie einfühlsamer oder entschuldigender für die jeweilige Situation sind. Dieses Konzept kann auch bei Vorschlägen für Contact Center-Agenten eingesetzt werden. Insgesamt wird so ein besseres Endbenutzererlebnis geschaffen, das zu einer stärkeren Bindung zwischen unseren Kunden und ihren Endbenutzern führt.

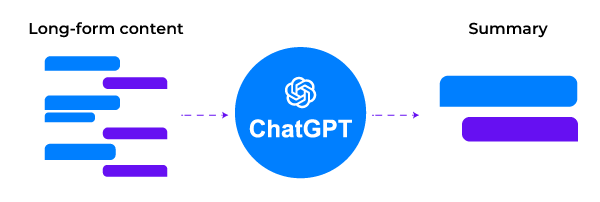

Zusammenfassungen und Suchfunktionen

Erkennungsmodelle schneiden bei langen Inhalten nicht immer gut ab. Die Zusammenfassung von Langform-Eingaben, bevor sie unsere Erkennungsmodelle durchlaufen, ist eine gute Möglichkeit, die Gesamterkennungsrate zu erhöhen und alle eingehenden Fragen mit höherer Zuverlässigkeit und Präzision zu beantworten.

Wenn wir Übergaben an menschliche Agenten organisieren, können diese Agenten auch ihre durchschnittliche Bearbeitungszeit reduzieren, wenn sie eine Zusammenfassung der Konversation zwischen dem Bot und dem Kunden lesen können. Die Agenten können sich schneller einarbeiten und eine bessere und schnellere erste Antwort geben. Jede geringfügige Verbesserung der Erstbeantwortungszeit ist auch mit einer höheren Zufriedenheitsrate verbunden, unabhängig davon, ob diese in NPS, CSAT oder CES ausgedrückt wird.

Die Zukunft beginnt heute

Abschließend bin ich neugierig, was Entwicklungen wie ChatGPT, LLMs und generative KI kurzfristig bringen werden und was unsere langfristigen Erwartungen sind, nachdem wir diese Human-in-the-Loop-Funktionen, die Sie vorhin angesprochen haben, veröffentlicht haben.

Was bedeutet ChatGPT für Unternehmen heute und in Zukunft?

Als eigenständiges Produkt ist ChatGPT so etwas wie ein persönlicher Assistent, der die individuelle Produktivität eines jeden Mitarbeiters als Ergänzung zu Werkzeugen wie Suchmaschinen und Wikis auf kurze Sicht (sprich: heute) steigern kann.

Da der Zugang zu den LLMs, die hinter Produkten wie ChatGPT und Bard stehen, den Weg in die Hände von Entwicklern finden wird, werden wir anfangen, spezifischere Implementierungen zu sehen, die Probleme auf Unternehmensebene lösen, anstatt nur die individuelle Produktivität von Wissensarbeitern zu steigern. Die Human-in-the-Loop-Anwendungsfälle in Produkten wie unserem sind ein perfektes Beispiel dafür.

Langfristig werden wir die Blackbox-Unsicherheiten überwinden, wenn die Fachleute sich mit der Verwendung dieser Modelle vertraut machen, um direkt mit den Verbrauchern zu sprechen. Genau wie damals bei NLP: Es wird einige Zeit dauern. Die Menschen müssen die richtigen Fähigkeiten und Metriken erlernen, um mit diesen Modellen auf dieser Ebene arbeiten zu können. Bei NLP sind F1-Scores, Präzision, Recall und vergleichbare Metriken für die Bewertung und das Training inzwischen allgemein bekannt. Heute finden Sie zahlreiche Veröffentlichungen, die ähnliche Metriken für NLG beschreiben. Der Übergang von den frühen Anwendern, die sich damit wohlfühlen, zu den frühen Mehrheitskäufern wird einige Zeit dauern. Wie viel Zeit genau? Ich glaube nicht, dass jemand eine Antwort darauf hat.

In der Zwischenzeit freuen wir uns darauf, im März unsere ersten LLM-Funktionen zu veröffentlichen und im weiteren Verlauf des Jahres noch mehr fortgeschrittene Fälle zu entwickeln.

Fortsetzung folgt!