- ¿Qué es ChatGPT exactamente?

- Pero, ¿Cómo se logra esto? Arman, ¿Cómo funciona ChatGPT?

- Espera, LLMs, IA generativa, parametros, ¿Qué es todo eso?

- ¡Oh, muy bien!, entonces es un chatbot que entiende los matices y puede generar sus propias respuestas. ¿Cuáles crees que son las principales ventajas y desventajas de este desarrollo?

- ChatGPT vs IA Conversacional

- ¿Cuál es la diferencia entre ChatGPT y Conversational AI Cloud?

- OK, ¿Entonces la audiencia y los casos de usos son muy diferentes?

- CM.com & ChatGPT

- ¿Qué papel puede desempeñar ChatGPT en nuestros productos?

- Entonces, cuéntanos, ¿Qué estamos construyendo en este momento y qué podemos esperar para el futuro?

- El futuro comienza hoy

- ¿Qué significa ChatGPT para los negocios hoy y en el futuro?

¿Qué es ChatGPT exactamente?

ChatGPT es una interfaz de chat basada en los modelos de lenguaje extenso (LLM) de la serie GPT de OpenAI. Puedes preguntarle lo que quieras y darle órdenes para generar información estructurada. Piense en casos de uso como hacer una pregunta, traducir un fragmento de texto, hacer cálculos basados en la descripción de un problema, generar código para una función en la que estás pensando, y la lista continúa...

Pero, ¿Cómo se logra esto? Arman, ¿Cómo funciona ChatGPT?

ChatGPT es un producto hecho por OpenAI basado en su serie GPT3.5. Es un modelo de lenguaje extenso (LLM) con 20 mil millones de parámetros, entrenados específicamente (léase: a mano) para modelar conversaciones. El modelo consiste en la comprensión del lenguaje natural (NLU) para comprender la entrada y la generación del lenguaje natural (NLG) para formular una respuesta. Especialmente en lo último, NLG ha dado pasos significativos con la introducción de ChatGPT, que habilita mejor los casos de uso de IA (Inteligencia Artificial) "generativos".

Espera, LLMs, IA generativa, parametros, ¿Qué es todo eso?

En pocas palabras, es un algoritmo que reconoce, resume, traduce, predice y genera texto. Puede hacer esto debido a los grandes conjuntos de datos utilizados para entrenar el modelo. Una de las formas de expresar su capacidad de aprender es cuantificando el número de parámetros. Un parámetro es una variable que constituye la parte del modelo que pudo aprender de los datos históricos proporcionados en el conjunto de datos subyacente. Entonces, la cantidad de parámetros dice algo sobre cuántos matices puede absorber un modelo. Hasta ahora, hemos visto una fuerte correlación entre la cantidad de parámetros que tiene un modelo y su capacidad para parecerse y generar respuestas y comportamientos similares a los humanos.

¡Oh, muy bien!, entonces es un chatbot que entiende los matices y puede generar sus propias respuestas. ¿Cuáles crees que son las principales ventajas y desventajas de este desarrollo?

Además de las oportunidades y los nuevos y poderosos casos de uso que brinda esta tecnología, veo la exageración que la rodea como la mayor ventaja. El extraordinario entusiasmo genera un aumento en la curiosidad y la demanda de tecnología en IA generativa. Pone el poder de la IA conversacional en exposición pública, y a la gente le encanta. En última instancia, esto impulsará aún más la innovación a medida que más personas y empresas se involucren.

También hay algunas desventajas tempranas. Hemos notado que durante las primeras etapas de este tipo de desarrollos, a muchas personas les resulta difícil hurgar entre el ruido y ver el valor comercial real. ChatGPT se percibe como una tecnología omnisciente y omnipotente, lo cual no es exactamente cierto. Es un modelo de IA conversacional que es excelente en la generación de lenguaje natural, pero no es perfecto. Comete errores. Está bien si sus usuarios entienden que ocasionalmente se equivoca y no es una panacea. Esta fase pasará, y lo que nos quedará será extremadamente impresionante.

ChatGPT vs IA Conversacional

Las conversaciones similares a las humanas suenan como algo que las personas también están tratando de lograr con Conversational AI Cloud.

¿Cuál es la diferencia entre ChatGPT y Conversational AI Cloud?

Buena pregunta. La serie GPT de OpenAI es una excelente aplicación de la "nueva" arquitectura de transformadores que Google presentó al mundo en 2017. Nuestra Conversational AI Cloud ha estado utilizando modelos de transformadores durante años. La gran diferencia es lo que una plataforma de IA conversacional ha creado en torno a esos modelos para ofrecer realmente valor empresarial a una organización.

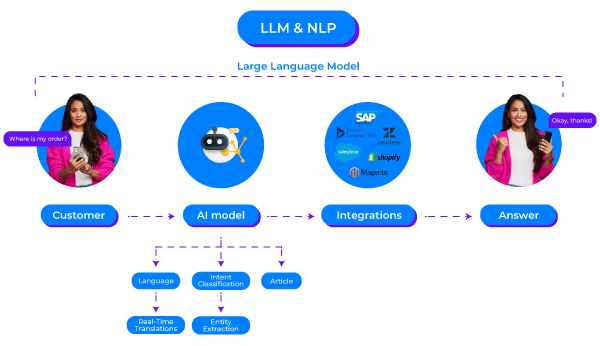

Conversational AI Cloud ayuda a las empresas a abordar problemas comerciales específicos mediante la automatización de conversaciones. El Procesamiento del Lenguaje Natural (NLP) está en el corazón de eso. Cuando se necesita automatizar muchas preguntas complejas, existen límites en lo que puede hacer con los modelos basados en reglas, por lo que emplear modelos de IA solo tiene sentido.

De forma aislada, esos modelos no hacen mucho. Las empresas quieren implementar IA en chat web, WhatsApp y otros canales. Quieren probar sus modelos antes de implementar nuevas versiones. Y quieren agregar o actualizar contenido fácilmente cuando necesitan actualizar sus precios o agregar un nuevo flujo de conversación, por ejemplo. Quieren obtener información sobre sus KPI, como el rendimiento del modelo o la tasa de desviación. ¿Y qué hay de las integraciones con sistemas existentes como OMS, CDP, CRM o ERP? Si no puedes ejecutar acciones reales con tu IA conversacional, como buscar o actualizar registros para brindar actualizaciones de estado a los clientes o cambiar tu información, entonces no puedes hacer mucho. ChatGPT no puede hacer nada de esto. Pero con Conversational AI Cloud puedes hacerlo. Por lo tanto, los modelos que usamos complementan un amplio conjunto de capacidades que forman nuestra solución completa.

Las respuestas proporcionadas por Conversational AI Cloud pueden adaptarse al contexto, pero los Copywriters de tu empresa las deben examinar para garantizar que las respuestas siempre sean objetivamente correctas, vayan de acuerdo con la marca y tengan el tone of voice correcto. Entonces, dependiendo de qué tan bien esté configurado tu entorno, lo peor que puede pasar es que tu IA, en un pequeño porcentaje de casos, responda con "No sé la respuesta a esa pregunta". Sin embargo, incluso esa frase se expresará exactamente como quieras que se exprese, y ese flujo está totalmente controlado. Todos estos principios dan como resultado un perfil de bajo riesgo para usar Conversational AI Cloud para interactuar con tus clientes.

Y esta es también la gran diferencia entre ChatGPT y Conversational AI Cloud. El comportamiento de ChatGPT es lo que llamarías una caja negra. Haz exactamente la misma pregunta 5 veces y obtendrás cinco respuestas diferentes (o no, nunca estarás seguro). A veces, una de esas respuestas sonará genial, pero también incorrecta. La IA que crea respuestas al momento, te ahorra un FTE (Full time equivalent), tal vez dos, en trabajo administrativo. Pero, al mismo tiempo, disminuye tu capacidad para ejercer el control, ser transparente y mantener la calidad. Por lo tanto, este perfil de riesgo de que la salida de IA generativa vaya directamente a tus clientes es significativamente mayor (al menos ahora que todavía estamos en los primeros días de esta tecnología). Pasaremos ese punto en algún momento, pero no hoy.

OK, ¿Entonces la audiencia y los casos de usos son muy diferentes?

Esa es una buena manera de resumirlo. Nuestros modelos seguirán evolucionando como lo han hecho en el pasado. Y estoy seguro de que los LLM que se están desarrollando y lanzando actualmente mejorarán en gran medida las capacidades de nuestros productos. No lo canibalizará; son dos cosas diferentes, complementarias.

CM.com & ChatGPT

Entonces, Arman, cuando dices que estos modelos mejorarán nuestros productos, ¿qué significa eso? ¿CM.com tiene algún plan para adoptar estos nuevos modelos?

¿Qué papel puede desempeñar ChatGPT en nuestros productos?

Vemos muchas oportunidades para mejorar nuestros productos y capacitar aún más a los usuarios de nuestros productos y el trabajo que han estado haciendo durante los últimos años. Ya sea para un diseñador de conversaciones en Conversational AI Cloud, un agente en Mobile Service Cloud o un especialista en marketing en Mobile Marketing Cloud. Todos están generando contenido. El uso de IA generativa para hacer sugerencias de contenido y hacer que nuestros clientes realicen una verificación final les quitará mucho trabajo.

Lo importante para nosotros es que no nos dejemos llevar por la exageración e integremos estas tecnologías por el simple hecho de incorporarlas. Solo queremos implementar características donde se agregue un valor significativo para nuestros productos y clientes. No se trata de etiquetar nuestras capacidades impulsadas por el marketing con "Esto impulsado por IA, aquello impulsado por IA". La IA generativa y los LLM son poderosos y tienen mucho sentido en muchos lugares, pero somos conscientes de las desventajas y nos aseguramos de que cualquier característica nueva que ofrecemos brinde calidad y valor.

Entonces, cuéntanos, ¿Qué estamos construyendo en este momento y qué podemos esperar para el futuro?

Me alegra que hayas preguntado. Tenemos algunas cosas en preparación que realmente aceleran nuestros corazones. Veamos algunos de ellos

Generación de contenido conversacional

Nuestro objetivo es lograr una puesta en marcha más rápida para nuestros clientes de Conversational AI, ya sea un cliente nuevo que acaba de comenzar o un cliente existente que desea agregar un nuevo flujo conversacional. Aunque nos enorgullecemos de la facilidad de uso, configurar modelos de intenciones y estructuras de artículos lleva tiempo. Tiempo que puede reducirse significativamente si tú, como diseñador de conversación, tienes lo que podría llamarse un escritor fantasma haciendo el trabajo pesado por ti. A corto plazo, eso significa solicitar a Conversational AI Cloud información sobre tu negocio. Digamos que es una empresa de servicios públicos. Puede compartir ese hecho y proporcionar algunos detalles menores sobre los productos y servicios, después de lo cual el LLM generará automáticamente preguntas y puntos de reconocimiento que muy bien puede esperar recibir de sus clientes. Puede considerar su salida después del mensaje como un borrador, revisarlo, probarlo y publicarlo. Pensar en ese contenido por ti mismo requiere mucho tiempo que podrías haber pasado en otro lugar.

Estamos comenzando con las intenciones y ya hemos identificado muchas otras áreas que se beneficiarán de este tipo de solución. Con el tiempo agregaremos más y más de estas capacidades a la cartera de CM.com.

LLMs para procesamiento de lenguaje natural en tiempo real

Una cosa en la que siempre estamos trabajando es en nuestros modelos NLP en nuestra Conversational AI Cloud y en facilitar la vida de los agentes en nuestra nube de servicios móviles. El objetivo aquí es mejorar nuestra infraestructura de NLP existente con el poder de los LLM mediante la investigación de temas como el reconocimiento de cero y pocos disparos. Y nuevamente, aquí, también nos enfocamos en el valor que esto aportará a nuestros productos. Los modelos de reconocimiento más sólidos significan menos escalamientos hacia agentes en vivo, y un enrutamiento más detallado cuando ocurren escalamientos da como resultado un tiempo de manejo promedio más bajo por conversación. Todo esto agregará un valor significativo a toda la plataforma CM.com. Aparte de eso, también estamos analizando temas como las correcciones ortográficas y gramaticales para ayudar a los diseñadores de conversación, los agentes del centro de contacto y los especialistas en marketing.

Personalización a través del sentimiento

ChatGPT es un buen ejemplo de cómo el contexto sentimental puede mejorar las respuestas. Cuando se detecta un sentimiento negativo, podemos contrarrestarlo reformulando las respuestas estáticas para ser más empáticos o disculparnos por la situación en cuestión. Este concepto también puede funcionar bien para sugerencias a los agentes del centro de contacto. En general, esto creará una mejor experiencia para el usuario final, lo que dará como resultado un vínculo más fuerte entre nuestros clientes y sus usuarios finales.

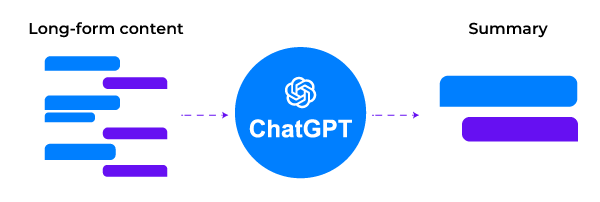

Resúmenes y capacidades de búsqueda

Los modelos de reconocimiento no siempre funcionan bien en contenido de formato largo. Resumir la entrada de formato largo antes de ejecutarla en nuestros modelos de reconocimiento es una buena manera de aumentar la tasa de reconocimiento general y responder a todas las preguntas entrantes con mayor confianza y precisión.

Cuando organizamos traspasos a agentes humanos, esos agentes también podrán reducir su tiempo promedio de manejo si pueden leer un resumen de la conversación entre el bot y el cliente. Los agentes pueden ponerse al día más rápido y proporcionar una primera respuesta mejor y más oportuna. Cualquier mejora menor en el tiempo de primera respuesta también se correlaciona con una mayor tasa de satisfacción, ya sea que se exprese en NPS (Net promoter scope), CSAT (Customer satisfaction score) o CES.

El futuro comienza hoy

Para concluir, tengo curiosidad por saber qué desarrollos como ChatGPT, LLM e IA generativa traerán a la mesa a corto plazo y cuáles son nuestras expectativas a más largo plazo después de que hayamos lanzado estas funciones humanas en el circuito, mencionadas anteriormente.

¿Qué significa ChatGPT para los negocios hoy y en el futuro?

Como producto independiente, ChatGPT es una especie de asistente personal que puede impulsar la productividad individual de cada empleado como complemento de herramientas como motores de búsqueda y wikis a muy corto plazo (léase: hoy)

A medida que el acceso a los LLM detrás de productos como ChatGPT y Bard llegue a manos de los desarrolladores, comenzaremos a ver implementaciones más específicas que resuelven problemas a escala comercial, en lugar de solo aumentos de productividad individual para los trabajadores del conocimiento. Los casos de uso de humanos en el circuito en productos como el nuestro son un ejemplo perfecto.

A largo plazo, eventualmente superaremos las incertidumbres de la caja negra a medida que los profesionales se familiaricen con el uso de estos modelos para hablar directamente con los consumidores. Al igual que lo hizo en el pasado con la PNL: llevará algún tiempo. Las personas necesitan aprender los conjuntos de habilidades y métricas correctos para trabajar con estos modelos en ese nivel. Para la NLP, las puntuaciones F1, la precisión, el recuerdo y las métricas comparables para la evaluación y la formación se han convertido en un conocimiento común. Hoy en día, puede encontrar muchos documentos que detallan métricas similares para NLG. La cascada desde que los primeros usuarios se sientan cómodos con eso hasta la mayoría temprana de compradores llevará algún tiempo. ¿Cuánto tiempo exactamente? No creo que nadie tenga la respuesta a eso.

Mientras tanto, nos emociona lanzar nuestras primeras funciones de LLM en marzo y seguir desarrollando casos aún más avanzados a medida que avanza el año.

¡Continuará!