- Che cos'è ChatGPT esattamente?

- Ma come fa ChatGPT a fare tutto questo? Arman, come funziona ChatGPT?

- Aspetta un attimo, LLM, AI generativa, parametri, di cosa si tratta?

- Va bene, quindi si tratta di un chatbot che comprende le sfumature e può generare le proprie risposte. Quali sono, a tuo parere, i principali vantaggi e svantaggi di questo sviluppo?

- ChatGPT vs Conversational AI

- Qual è la differenza tra ChatGPT e Conversationa AI Cloud?

- Quindi, il pubblico e i casi d'uso sono molto diversi?

- CM.com e ChatGPT

- Che ruolo può svolgere ChatGPT nei nostri prodotti?

- Quindi raccontaci meglio, cosa stiamo costruendo in questo momento e cosa possiamo aspettarci per il futuro?

- Il futuro inizia oggi

- Cosa significa ChatGPT per le imprese oggi e in futuro?

Che cos'è ChatGPT esattamente?

ChatGPT è un'interfaccia di chat basata sui Grandi Modelli Linguistici della serie GPT (Large Language Models) di OpenAI. Puoi chiedergli quello che vuoi e dargli comandi per generare informazioni strutturate. Pensate a casi d'uso come fare una domanda, tradurre un pezzo di testo, effettuare calcoli basati sulla descrizione di un problema, generare codice per una funzionalità che stai pensando, e molto altro...

Ma come fa ChatGPT a fare tutto questo? Arman, come funziona ChatGPT?

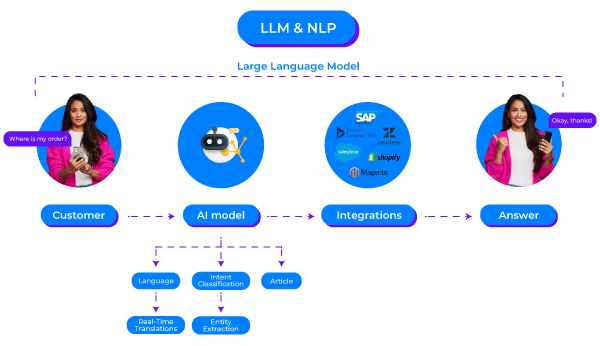

Dunque, ChatGPT è un prodotto realizzato da OpenAI basato sulla serie GPT3.5. È un Grande Modello di Lingua (LLM) con 20 miliardi di parametri, specificamente addestrato (leggasi: manualmente) per modellare conversazioni. Il modello è composto da Comprensione del Linguaggio Naturale (NLU) per comprendere l'input e Generazione del Linguaggio Naturale (NLG) per formulare una risposta. In particolare, quest'ultimo aspetto, NLG, ha fatto significativi passi avanti con l'introduzione di ChatGPT, migliorando la capacità dell'AI "generativa".

Aspetta un attimo, LLM, AI generativa, parametri, di cosa si tratta?

In poche parole, è un algoritmo che riconosce, riassume, traduce, predice e genera testo. Può farlo grazie all'enorme quantità di dati utilizzati per addestrare il modello. Uno dei modi per esprimere la sua capacità di apprendimento è quantificare il numero di parametri. Un parametro è una variabile che costituisce quella parte del modello che è stata in grado di apprendere dai dati storici forniti nel dataset sottostante. Quindi, il numero di parametri dice qualcosa su quante sfumature un modello può assorbire. Finora, abbiamo visto una forte correlazione tra il numero di parametri che un modello ha e la sua capacità di assomigliare e generare risposte e comportamenti simili a quelli umani.

Va bene, quindi si tratta di un chatbot che comprende le sfumature e può generare le proprie risposte. Quali sono, a tuo parere, i principali vantaggi e svantaggi di questo sviluppo?

Oltre alle opportunità che questa tecnologia porta con sé, vedo l'enorme entusiasmo che la circonda come il suo maggior vantaggio. L'entusiasmo straordinario genera un aumento della curiosità e della richiesta di tecnologia nell'AI generativa. Mette in mostra il potere dell'AI conversazionale al pubblico, e le persone ne sono entusiaste. Alla fine, ciò stimolerà ulteriormente l'innovazione, coinvolgendo sempre più persone e aziende.

Ci sono anche alcuni svantaggi iniziali. Abbiamo notato che durante le prime fasi di questo tipo di sviluppi, molte persone trovano difficile vedere il vero valore commerciale. ChatGPT è visto come una tecnologia onniscente e onnipotente, il che non è del tutto vero. È un modello di AI conversazionale che è ottimo nella generazione del linguaggio naturale, ma non è perfetto. Fa degli errori. È importante che i suoi utenti capiscano che occasionalmente sbaglia. Questa fase passerà, e ciò che rimarrà sarà estremamente impressionante.

ChatGPT vs Conversational AI

Conversazioni umane sembrano essere qualcosa che le persone stanno cercando di raggiungere anche con Conversational AI Cloud.

Qual è la differenza tra ChatGPT e Conversationa AI Cloud?

Buona domanda. La serie GPT di OpenAI è una grande applicazione della "nuova" architettura trasformatore che Google ha introdotto nel 2017. La nostra Conversational AI Cloud utilizza modelli a trasformatori da anni. La grande differenza è ciò che una piattaforma Conversational AI ha costruito attorno a quei modelli per offrire un vero valore aziendale per un'organizzazione.

Conversational AI Cloud aiuta le aziende ad affrontare specifici problemi aziendali automatizzando le conversazioni. L'elaborazione del linguaggio naturale (NLP) è al centro di questo. Quando è necessario automatizzare molte e/o complesse domande, ci sono limiti a ciò che è possibile fare con modelli basati su regole, quindi impiegare modelli di AI ha senso.

Le aziende vogliono utilizzare l'AI su webchat, WhatsApp, e altri canali. Vogliono testare i loro modelli prima di rilasciare nuove versioni e desiderano aggiungere o aggiornare facilmente i contenuti quando devono aggiornare i loro prezzi o aggiungere un nuovo flusso conversazionale. Vogliono ottenere informazioni sulle loro KPI come la performance del modello o il tasso di deflessione. E che dire dell'integrazione con i sistemi esistenti come un OMS, CDP, CRM o ERP? Se non è possibile eseguire azioni reali con la tua AI conversazionale, come recuperare o aggiornare i record per fornire aggiornamenti sullo stato ai clienti o modificare le loro informazioni, allora non puoi fare molto. ChatGPT non può fare niente di tutto ciò. Ma con Conversational AI Cloud, si può. Quindi, i modelli che usiamo "sotto il cofano" completano un ampio set di funzionalità che formano la nostra soluzione completa.

Le risposte fornite da Conversational AI Cloud possono adattarsi al contesto ma devono essere verificate in seguito dal copywriter della tua azienda per garantire che le risposte siano sempre corrette, in linea con il brand e abbiano il tono di voce giusto. Quindi, il peggio che può accadere è che il tuo AI, in una percentuale minore di casi, risponda con "Non conosco la risposta a quella domanda". Tuttavia, anche quella frase sarà formulata esattamente come desideri e quel flusso sarà completamente controllato. Tutti questi principi si traducono in un profilo a basso rischio per l'utilizzo di Conversational AI Cloud per interagire con i tuoi clienti.

E questa è anche immediatamente la grande differenza tra ChatGPT e Conversational AI Cloud. Il comportamento di ChatGPT è ciò che si potrebbe definire una scatola nera. Fai la stessa esatta domanda 5 volte e otterrai cinque risposte diverse (o non lo farai, non sarai mai sicuro). A volte, una di quelle risposte sembrerà ottima ma anche fattualmente sbagliata. La tua AI che inventa risposte al volo ti fa risparmiare uno o due FTE nel lavoro amministrativo. Ma contemporaneamente, diminuisce la tua capacità di esercitare il controllo, essere trasparente e mantenere la qualità. Quindi, questo profilo di rischio di avere un'uscita generata dall'AI che va direttamente ai tuoi clienti è significativamente più alto (almeno finché siamo ancora nei primi giorni di questa tecnologia). Arriveremo a superare questo punto in qualche momento, ma non oggi.

Quindi, il pubblico e i casi d'uso sono molto diversi?

È un buon modo per riassumere la situazione. I nostri modelli continueranno ad evolversi come hanno fatto in passato. E sono sicuro che i LLM (Large Language Models) attualmente in fase di sviluppo e rilascio miglioreranno notevolmente le capacità dei nostri prodotti. Non li sostituiranno; sono due cose diverse e complementari.

CM.com e ChatGPT

Quindi, Arman, quando dici che questi modelli miglioreranno i nostri prodotti, cosa intendi? E CM.com ha qualche piano per adottare questi nuovi modelli?

Che ruolo può svolgere ChatGPT nei nostri prodotti?

Vediamo molte opportunità per migliorare i nostri prodotti e consentire ulteriormente agli utenti dei nostri prodotti di svolgere il lavoro che hanno fatto negli ultimi anni. Che si tratti di un progettista di conversazioni in Conversational AI Cloud, di un agente in Mobile Service Cloud, o di un responsabile marketing nella nostra Mobile Marketing Cloud. Tutti generano contenuti. Utilizzare l'AI generativa per suggerire contenuti e far sì che i nostri clienti eseguano un controllo finale libererà molte delle loro responsabilità.

La cosa importante per noi è non lasciarci trasportare dall'entusiasmo e integrare queste tecnologie solo per il gusto di farlo. Vogliamo solo implementare funzionalità dove si aggiunga un valore significativo ai nostri prodotti e ai nostri clienti. Non ci interessa etichettare le nostre capacità con slogan "potenziati da AI". L'AI generativa e gli LLM sono potenti e hanno senso in molti contesti, ma siamo consapevoli degli svantaggi e ci assicuriamo che qualsiasi nuova funzionalità che offriamo sia di qualità e valore.

Quindi raccontaci meglio, cosa stiamo costruendo in questo momento e cosa possiamo aspettarci per il futuro?

Domanda interessante. Abbiamo alcune cose in fase di sviluppo. Vediamone alcune.

Generazione di contenuti conversazionali

Il nostro obiettivo è quello di raggiungere un go-live più veloce per i nostri clienti di conversational AI, sia che si tratti di un nuovo cliente o di un cliente esistente che desidera aggiungere un nuovo flusso conversazionale. La configurazione dei modelli e delle strutture degli articoli richiede tempo. Tempo che può essere significativamente ridotto se, come conversation designer, hai ciò che potresti definire come un ghostwriter che fa il lavoro pesante al posto tuo. A breve termine, ciò significa fornire informazioni sulla tua attività a Conversational AI Cloud. Se sei ad esempio un'azienda di servizi pubblici, puoi condividere questo fatto e fornire alcuni dettagli minori sui tuoi prodotti e servizi, dopodiché LLM genererà automaticamente domande e punti di riconoscimento che potresti benissimo aspettarti di ricevere dai tuoi clienti. Puoi considerare l'output dopo la richiesta come una bozza, rivederlo, testarlo e pubblicarlo. Pensare a quel contenuto da soli richiede molto tempo che potresti impiegare altrove.

Stiamo partendo dagli intenti e abbiamo già identificato molte altre aree che trarranno beneficio da questo tipo di soluzione. Nel tempo, aggiungeremo sempre più di queste capacità al portafoglio di CM.com.

LLM per l'elaborazione del linguaggio naturale in tempo reale

Una cosa su cui stiamo sempre lavorando sono i nostri modelli NLP nella nostra Conversational AI Cloud e a rendere più facile la vita degli agenti nel nostro Mobile Service Cloud. L'obiettivo qui è quello di migliorare la nostra infrastruttura NLP esistente con la potenza dei LLM, investigando argomenti come il riconoscimento zero e few-shot. E ancora una volta, qui ci concentriamo anche sul valore che questo apporterà ai nostri prodotti. Modelli di riconoscimento più forti significano meno escalation verso gli agenti in diretta e un instradamento più fine quando le escalation si verificano, con un tempo medio di gestione inferiore per ogni conversazione. Tutto ciò aggiungerà un valore significativo all'intera piattaforma CM.com. Oltre a ciò, stiamo anche esaminando argomenti come la correzione di ortografia e grammatica per aiutare i progettisti di conversazioni, gli agenti dei centri di contatto e i responsabili marketing.

La personalizzazione attraverso il sentimento

ChatGPT fa un buon argomento su come il contesto sentimentale possa migliorare le risposte. Quando viene rilevato un sentimento negativo, possiamo controbilanciare riformulando le risposte statiche in modo più empatico o scusandoci per la situazione in questione. Questo concetto può funzionare anche bene per suggerimenti agli agenti dei centri di contatto. Nel complesso, ciò creerà un'esperienza utente migliore che porterà a un legame più forte tra i nostri clienti e i loro utenti finali.

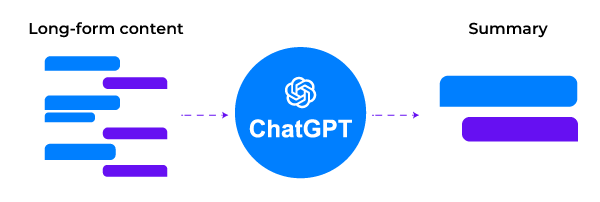

Sommario e capacità di ricerca

I modelli di riconoscimento non sempre funzionano bene su contenuti di lunghezza maggiore. Riassumere l'input di lunghezza maggiore prima di farlo passare attraverso i nostri modelli di riconoscimento è un buon modo per aumentare il tasso di riconoscimento complessivo e rispondere a tutte le domande in arrivo con maggiore sicurezza e precisione.

Quando organizziamo la transizione a degli agenti umani, questi ultimi saranno in grado di ridurre il tempo medio di gestione se possono leggere un riassunto della conversazione tra il bot e il cliente. Gli agenti possono mettersi al passo più velocemente e fornire una risposta iniziale migliore e tempestiva. Qualsiasi miglioramento minore nel tempo di risposta iniziale è correlato ad un tasso di soddisfazione più elevato, che sia espresso tramite NPS, CSAT o CES.

> The first implementations are here! Now live in the CM.com platform.

> The first implementations are here! Now live in the CM.com platform.

Il futuro inizia oggi

Per concludere, sono curioso di sapere quali sviluppi come ChatGPT, LLM e l'AI generativa porteranno sul tavolo a breve termine e quali sono le nostre aspettative a lungo termine dopo aver rilasciato le funzionalità umane che hai accennato in precedenza.

Cosa significa ChatGPT per le imprese oggi e in futuro?

ChatGPT è qualcosa di simile ad un assistente personale che può aumentare la produttività individuale di ogni dipendente come integrazione di strumenti come motori di ricerca e wiki nel breve termine (leggasi: oggi).

Man mano che l'accesso alle LLM (linguaggio naturale generativo) di prodotti come ChatGPT e Bard si diffonderà nelle mani dei sviluppatori, inizieremo a vedere implementazioni più specifiche che risolvono problemi su scala aziendale, anziché solo aumentare la produttività individuale dei lavoratori. I casi d'uso che coinvolgono l'interazione umana in prodotti come il nostro sono un esempio perfetto.

A lungo termine, alla fine supereremo le incertezze delle "scatole nere" mentre i professionisti si familiarizzano con l'utilizzo di questi modelli per parlare direttamente con i consumatori. Proprio come è successo con il NLP: ci vorrà del tempo. Le persone devono imparare le giuste competenze e metriche per lavorare con questi modelli a quel livello. Per il NLP, punteggi F1, precisione, richiamo e metriche comparabili per valutazione e formazione sono diventati conoscenze comuni. Oggi, è possibile trovare molti documenti che descrivono metriche simili per l'NLG. Il passaggio dai primi utilizzatori che si sentono a proprio agio con queste metriche agli acquirenti della maggioranza richiederà del tempo. Quanto tempo esattamente? Non penso che nessuno abbia la risposta a questa domanda.

Nel frattempo, siamo molto entusiasti di rilasciare le nostre prime funzionalità LLM a marzo e continuare a spingere durante l'anno.

Continua a seguirci!