- Wat is ChatGPT nu eigenlijk?

- Maar hoe kan de bot dit allemaal? Arman, hoe werkt ChatGPT?

- Wacht even, LLMs, generative AI, parameters, hoe zit dat?

- Oké, een chatbot die nuance begrijpt en zelf antwoorden kan genereren dus. Wat zijn volgens jou de belangrijkste voor- en nadelen van deze ontwikkeling?

- ChatGPT vs Conversational AI

- Wat is het verschil tussen ChatGPT en Conversational AI?

- Oké, de doelgroep en de use cases zijn dus de grootste verschillen?

- CM.com & ChatGPT

- Welke rol kan ChatGPT spelen in de producten van CM.com?

- Vertel, wat zijn we aan het bouwen, en wat kunnen we in de toekomst verwachten?

- De toekomst begint vandaag

- Wat betekent ChatGPT voor bedrijven vandaag en in de toekomst?

Wat is ChatGPT nu eigenlijk?

ChatGPT is een “conversational interface”, waar je op een menselijke manier een bot vraagt om iets voor je te doen of te maken. Dit kan van alles zijn: antwoord op je vraag, specifieke uitleg, een tekst schrijven, vertalingen, of een code voor je maken. In het gesprek kom je eigenlijk steeds verder.

Maar hoe kan de bot dit allemaal? Arman, hoe werkt ChatGPT?

ChatGPT is dus een product van OpenAI, gebaseerd op de GPT3.5-serie. Het is een Large Language Model (LLM) met 20 miljard parameters, specifiek getraind (lees: met de hand) om gesprekken te modelleren. Het model bestaat uit Natural Language Understanding (NLU) om input te begrijpen en Natural Language Generation (NLG) om een antwoord te formuleren. Vooral dat laatste, NLG, heeft met de introductie van ChatGPT grote stappen vooruit gezet, waardoor "generatieve" AI use cases steeds beter mogelijk worden.

Wacht even, LLMs, generative AI, parameters, hoe zit dat?

Simpel gezegd is het een algoritme dat tekst herkent, samenvat, vertaalt, voorspelt en genereert. Het kan dit doen dankzij de enorme datasets die worden gebruikt om het model te trainen. Eén van de manieren om het leervermogen uit te drukken is met het aantal parameters. Een parameter is een variabele die dat deel van het model vormt op basis van historische gegevens uit de onderliggende dataset. Het aantal parameters zegt dus iets over hoeveel nuances een model kan verwerken. Tot nu toe hebben we een sterke relatie gezien tussen het aantal parameters dat een model heeft en het vermogen om op menselijke reacties en gedrag te lijken en deze te genereren.

Oké, een chatbot die nuance begrijpt en zelf antwoorden kan genereren dus. Wat zijn volgens jou de belangrijkste voor- en nadelen van deze ontwikkeling?

Naast de kansen en krachtige nieuwe use cases die deze technologie met zich meebrengt, zie ik de hype eromheen als het grootste voordeel. Het ongekende enthousiasme zorgt voor meer interesse en vraag naar technologie in Generative AI. Het zet de potentie van conversational AI in de schijnwerpers, en mensen zijn er gek op. Uiteindelijk gaat dit de innovatie verder stimuleren als meer mensen en bedrijven meedoen.

Toch zijn er ook (nog) enkele nadelen. We hebben gemerkt dat veel mensen het in het beginstadium van dit soort ontwikkelingen moeilijk vinden om door de ruis heen te prikken en de echte zakelijke waarde te zien. ChatGPT wordt gezien als een alwetende en almachtige technologie, wat niet helemaal waar is. Het is een conversationeel AI-model dat uitblinkt in Natural Language Generation, maar het is niet perfect. Het maakt fouten. Het is prima als gebruikers begrijpen dat het af en toe dingen fout doet en geen wondermiddel is. Ook deze fase gaat voorbij, en wat we dan overhouden is ontzettend indrukwekkend.

ChatGPT vs Conversational AI

Dat menselijke gesprek klinkt als iets wat bedrijven ook proberen te bereiken met Conversational AI Cloud.

Wat is het verschil tussen ChatGPT en Conversational AI?

Goede vraag. De GPT-serie van OpenAI is een mooi voorbeeld van de "nieuwe" transformatorarchitectuur die Google in 2017 aan de wereld introduceerde. Onze Conversational AI Cloud maakt al jaren gebruik van transformator modellen. Het grote verschil is wat een Conversational AI Platform rondom die modellen heeft gebouwd om echt bedrijfswaarde te bieden voor een organisatie.

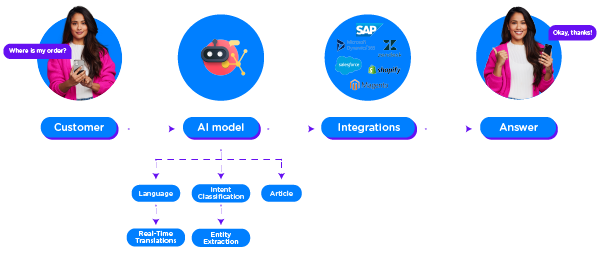

Conversational AI Cloud helpt bedrijven om specifieke vraagstukken aan te pakken door gesprekken te automatiseren. Natural Language Processing (NLP) staat daarbij centraal. Wanneer je veel en/of complexe vragen moet automatiseren, zijn er grenzen aan wat je kunt doen met rule-based modellen, dus is de inzet van AI-modellen alleen maar logisch.

Op zichzelf doen die modellen niet veel. Bedrijven willen AI inzetten op webchat, WhatsApp en andere kanalen. Ze willen hun modellen testen voordat ze nieuwe versies inzetten. En ze willen gemakkelijk content toevoegen of bijwerken als ze bijvoorbeeld hun prijzen aanpassen of een nieuwe gespreksflow moeten toevoegen. Ze willen inzicht krijgen in hun KPI's zoals de prestaties van het model of "deflection rate". En hoe zit het met integraties met bestaande systemen zoals een OMS, CDP, CRM of ERP? Als je geen concrete acties kunt uitvoeren met je Conversational AI, zoals het ophalen of bijwerken van data om klanten statusupdates te geven of hun informatie te wijzigen, dan kun je niet veel doen. ChatGPT kan dit allemaal niet. Met Conversational AI Cloud kan dit wel. De modellen die wij "onder de motorkap" gebruiken, vormen een aanvulling op een brede reeks functionaliteiten die onze volledige oplossing vormen.

Antwoorden van Conversational AI Cloud kunnen worden aangepast aan de context, maar worden gecontroleerd door copywriters in jouw bedrijf om ervoor te zorgen dat antwoorden altijd feitelijk correct zijn, bij het merk passen en de juiste toon hebben. Dus, afhankelijk van hoe goed je instelling is, is het ergste dat kan gebeuren dat je AI in een klein percentage van de gevallen antwoordt met "Ik weet het antwoord op die vraag niet". Maar zelfs die zin wordt precies zo geformuleerd als jij wilt, en de flow wordt volledig gecontroleerd. Al deze principes leiden tot een laag risicoprofiel voor het gebruik van Conversational AI Cloud om met je klanten te communiceren.

En dit is ook meteen het grote verschil tussen ChatGPT en Conversational AI Cloud. Het gedrag van ChatGPT is wat je een black box zou noemen. Stel exact dezelfde vraag 5 keer, en je krijgt vijf verschillende antwoorden (of niet, dat weet je nooit zeker). Soms zal één van die antwoorden geweldig klinken, maar zal ook feitelijk onjuist zijn. De AI die ter plekke antwoorden verzint, bespaart je een FTE, misschien twee, aan administratief werk. Maar tegelijkertijd vermindert het je controle- en transparantievermogen en, nog belangrijker, je kwaliteit. Dit risicoprofiel van generatieve AI-output die rechtstreeks naar je klanten gaat, is dus aanzienlijk hoger (nu we ons nog in de begindagen van deze technologie bevinden). Ooit zullen we dat punt achter ons laten, maar niet vandaag.

Oké, de doelgroep en de use cases zijn dus de grootste verschillen?

Zo zou je het kunnen stellen. Onze modellen zullen zich blijven ontwikkelen zoals in het verleden. En ik ben er zeker van dat de LLM's die momenteel worden ontwikkeld en uitgebracht de mogelijkheden van onze producten sterk zullen verbeteren. Het zal niet kannibaliseren; het zijn twee verschillende, complementaire dingen.

CM.com & ChatGPT

Dus, Arman, als je zegt dat deze modellen onze producten zullen verbeteren, wat betekent dat dan? En heeft CM.com plannen om deze nieuwe modellen te implementeren?

Welke rol kan ChatGPT spelen in de producten van CM.com?

We zien veel mogelijkheden om onze producten te verbeteren en de gebruikers van onze producten en het werk dat ze de afgelopen jaren hebben gedaan verder mogelijk te maken. Of het nu gaat om een conversation designer in Conversational AI Cloud, een agent in Mobile Service Cloud, of een marketeer in onze Mobile Marketing Cloud. Door generatieve AI te gebruiken om suggesties voor content te doen en onze klanten een eindcontrole te laten uitvoeren, wordt hen veel werk uit handen genomen.

Het belangrijkste voor ons is dat we ons niet laten meeslepen door de hype en deze technologieën alleen maar integreren om ze te integreren. We willen alleen functies implementeren die een significante toegevoegde waarde hebben voor onze producten en klanten. Het gaat ons niet om marketinggedreven labels van onze mogelijkheden met "AI-powered dit, AI-powered dat". Generatieve AI en LLM's zijn krachtig en op veel plaatsen zinvol, maar we zijn ons bewust van de nadelen en zorgen ervoor dat alle nieuwe functies die we aanbieden kwaliteit en waarde leveren.

Vertel, wat zijn we aan het bouwen, en wat kunnen we in de toekomst verwachten?

Ik ben blij dat je dat vraagt. We hebben wat projecten in ontwikkeling waar ons hart sneller van gaat kloppen. Laten we er een paar bekijken:

Conversationele inhoud genereren

Ons doel is een snellere go-live voor onze Conversational AI-klanten, of het nu gaat om een nieuwe klant die net begint of een bestaande klant die een nieuwe gespreksflow wil toevoegen. En hoewel we trots zijn op ons gebruiksgemak, kost het opzetten van intentiemodellen en artikelstructuren tijd. Tijd die sterk kan worden verminderd als je als conversatieontwerper een zogenaamde ghostwriter hebt die het zware werk voor je doet. Op korte termijn betekent dit dat je Conversational AI Cloud informatie geeft over je bedrijf. Stel dat je een nutsbedrijf bent. Je kunt dat feit delen en wat kleine details geven over je producten en diensten - waarna de LLM automatisch vragen en herkenningspunten genereert die je heel goed van je klanten kunt verwachten. Je kunt je output na de prompt zien als een concept, dat je kunt herzien, testen en publiceren. Zelf nadenken over die content kost veel tijd die je anders had kunnen besteden.

We beginnen met intenties, en we hebben al meerdere andere gebieden geïdentificeerd die profiteren van dit type oplossing. Gaandeweg zullen we steeds meer van deze mogelijkheden aan het CM.com-portfolio toevoegen.

LLM's voor natuurlijke taalverwerking in real time

Eén ding waar we altijd aan werken zijn onze NLP-modellen in onze Conversational AI Cloud, en het makkelijker maken van het leven van agents in onze Mobile Service Cloud. Het doel is om onze bestaande NLP-infrastructuur te verbeteren met de kracht van LLM's door topics als zero- en few-shot recognition te onderzoeken. En ook hier richten we ons op de waarde die dit oplevert voor onze producten. Sterkere herkenningsmodellen leiden tot minder escalaties naar live agents, en een meer verfijnde routering wanneer escalaties zich toch voordoen, resulteert in een lagere gemiddelde afhandelingstijd per gesprek. Dit alles zal significante waarde toevoegen aan het hele CM.com platform. Daarnaast kijken we ook naar onderwerpen als spelling- en grammaticacorrecties om conversation designers, klantenservicemedewerkers en marketeers te helpen.

Personalisatie door sentiment

ChatGPT laat goed zien hoe sentimentele context antwoorden kan verbeteren. Wanneer negatief sentiment wordt opgemerkt, kunnen we dit compenseren door statische antwoorden anders te formuleren, zodat ze empathischer of verontschuldigender zijn voor die specifieke situatie. Dit concept kan ook goed werken voor suggesties aan klantenservice agents. In het algemeen zorgt dit voor een betere eindgebruikerservaring, wat leidt tot een sterkere band tussen onze klanten en hun eindgebruikers.

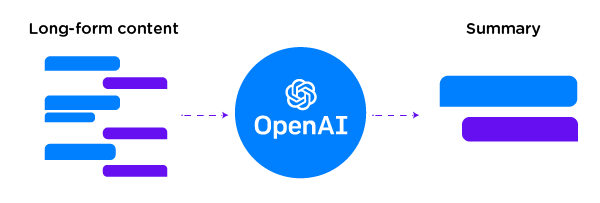

Samenvattingen en zoekmogelijkheden

Herkenningsmodellen presteren niet altijd goed op long-form content. Het samenvatten van lange input voordat deze door onze herkenningsmodellen wordt gehaald, is een goede manier om het totale herkenningspercentage te verhogen en alle inkomende vragen met meer vertrouwen en precisie te beantwoorden.

Wanneer we het gesprek overdragen aan menselijke medewerkers, kunnen die medewerkers ook hun gemiddelde verwerkingstijd verminderen als ze een samenvatting van het gesprek tussen de bot en de klant kunnen lezen. De medewerkers kunnen sneller reageren en een beter en sneller eerste antwoord geven. Elke kleine verbetering in de eerste reactietijd hangt ook samen met een hogere tevredenheid, of die nu wordt uitgedrukt in NPS, CSAT of CES..

> De eerste implementaties zijn live! Nu in het CM.com platform.

> De eerste implementaties zijn live! Nu in het CM.com platform.

De toekomst begint vandaag

Om af te sluiten, ben ik benieuwd wat ontwikkelingen als ChatGPT, LLM's en generatieve AI op zullen leveren. Wat zijn jouw verwachtingen op de korte termijn en de langere termijn, nadat we deze human-in-the-loop-functies, waar je het eerder over had, hebben geïntroduceerd?

Wat betekent ChatGPT voor bedrijven vandaag en in de toekomst?

Als zelfstandig product is ChatGPT zoiets als een persoonlijke assistent die op zeer korte termijn (lees: vandaag) de individuele productiviteit van elke werknemer kan verhogen als aanvulling op tools zoals zoekmachines en wiki's.

Naarmate de toegang tot de LLM's achter producten als ChatGPT en Bard in handen komt van developers, zullen we meer specifieke implementaties gaan zien die zakelijke problemen oplossen, in plaats van alleen individuele productiviteitsverhogingen voor werknemers. De human-in-the-loop use cases in producten als de onze zijn daar een perfect voorbeeld van.

Op de lange termijn raken we uiteindelijk voorbij de black-box onzekerheden naarmate professionals vertrouwd raken met het gebruik van deze modellen om rechtstreeks met consumenten te spreken. Net als destijds met NLP: het zal enige tijd duren. Mensen moeten de juiste vaardigheden en metrics leren om op dat niveau met deze modellen te kunnen werken. Voor NLP zijn F1-scores, precisie, recall en vergelijkbare metrics voor evaluatie en training inmiddels algemeen bekend. Vandaag de dag zijn er genoeg artikelen te vinden waarin soortgelijke metrics voor NLG worden beschreven. De overgang van early adopters die zich hiermee vertrouwd voelen naar de early majority kopers duurt nog wel even. Hoeveel tijd precies? Ik denk niet dat iemand daar een antwoord op heeft.

In de tussentijd zijn we enorm enthousiast om in maart onze eerste LLM-functies te lanceren en te werken aan nog geavanceerdere zaken in de loop van het jaar.

Wordt vervolgd!